|

Economie des nouvelles

technologies

Chapitre 6

Informatique

- Matériel

- Technologies

de base

- Mémoires de

masse

- Concurrence entre

mainframe et micro-ordinateur

- Coût

comparé des micro-ordinateurs et mainframes

- Evolution du prix

- Logiciel

- Langages

- Interfaces

utilisateurs

- Evolution

- Marché

- Conclusion

L’essentiel de la synergie propre au STC se concrétise

dans l’informatique. Les ordinateurs tirent parti des progrès de la

microélectronique ; ils facilitent l’automatisation ; programmables, leurs

logiciels peuvent être adaptés aux missions les plus diverses. C’est autour des

techniques informatiques, qu’il s’agisse du matériel, du logiciel ou des

usages, que s’articule la dynamique du STC.

C’est à dessein que nous avons mentionné " les

usages " dans la liste des " techniques " informatiques.

C’est dans la couche des usages en effet que se trouve le point critique lorsque

l’innovation modifie rapidement et continuellement le domaine du possible ;

c’est là que résident les blocages, les obstacles, qui s’opposent à la pleine

mise en valeur de la synergie. Nous y reviendrons dans la partie suivante.

Ici nous considérerons pour l’essentiel les deux couches

" matériel " et " logiciel " de

l’informatique, les usages n’étant évoqués que dans la mesure où ils jouent

un rôle dans l’élargissement du marché et le jeu de l’économie

d’échelle.

La fonction de production de l’informatique est à coût

fixe. C’est évident pour le logiciel, dont le coût est un coût de pure conception.

Pour le matériel, cela concerne les composants les plus nobles (processeur et mémoire

vive), le reste étant constitué d’une carcasse et d’un câblage, ainsi que de

quelques équipements (disques, écrans) produits selon des techniques très

automatisées.

Cette fonction de coût se retrouve dans les matériels

utilisant les mêmes composants que l’ordinateur : le logiciel représente 80 %

du coût des autocommutateurs des réseaux de télécommunications, et constitue, associé

à la microélectronique, une part croissante du coût de production des avions, des

automobiles etc. La transmission et le traitement de l’information, autrefois

assurés par les engrenages, chaînes etc. de la mécanique, sont assurés par des

réseaux, mémoires et processeurs qui libèrent l’information des métaphores

mécaniques. Il en résulte une forte simplification des parties mécaniques des machines

et une augmentation de leurs performances. La fonction de production à coût fixe

caractéristique du STC se généralise ainsi, à partir des technologies

microélectroniques et informatiques, vers tous les autres types de produits.

Matériel

50 ans séparent le premier ordinateur (50 tonnes, 25 kW,

quelques milliers de positions de mémoire, cent instructions par seconde) du

microprocesseur Pentium (quelques grammes, 25 watts, 8 à 32 Megaoctets de mémoire, 100

MIPS). L’évolution n’est pas terminée : la loi de Moore (1) (doublement de la

complexité des circuits intégrés tous les deux ans, soit une croissance de 41 % par an)

se vérifie depuis le début des années 70. Les chercheurs pensent qu’elle jouera

jusque vers 2010 (cf. annexe II).

Technologies de base

Les techniques de production des circuits intégrés (2), qui

sont à la base des microprocesseurs et des mémoires vives, sont fortement automatisées.

La production des cristaux de silicium, matière première de

base, suit un processus chimique dont le coût de revient est minime.

A partir d’un germe de cristal, la silice hautement purifiée

croît en un long cylindre à l’intérieur d’un creuset à haute température.

Puis ce cylindre est découpé en tranches fines par une scie au diamant.

Les tranches de silicium sont ensuite soumises à des manipulation de type

photographique, qui gravent les couches incorporant la logique et la physique du circuit

intégré. Le coût de production des circuits intégré est donc essentiellement composé

(a) du coût de conception des " masques " qui permettent le dessin

des circuits, (b) du coût des équipements automatiques et hautement protégés

(notamment contre les poussières) qui assurent la production.

Chaque tranche est nettoyée à l’acide, puis placée dans un

four à haute température où sa surface est oxydée.

La tranche est recouverte d’un produit photosensible, et le dessin du premier

niveau du circuit est projeté à travers un masque par un faisceau de rayons

ultraviolets.

Puis les surfaces impressionnées par ce faisceau sont enlevées par de l’acide. Le

processus est répété pour chaque niveau du circuit.

La tranche est traitée avec des impuretés chimiques positives ou négatives, qui

créent les zones conductrices.

Finalement, elle est revêtue d’un enduit qui protège sa surface et empêche les

fuites de charges électriques.

Les puces comportant des fautes sont repérées sur la tranche par inspection visuelle

et test informatique.

Puis les puces sont découpées, collées sur un support, de minuscules fils sont

soudés pour connecter le support aux points de contact de la puce, un couvercle est

placé sur la puce et scellé pour la protéger.

Le microprocesseur est mis pendant plusieurs jours dans un four à basse température

pour simuler son utilisation à long terme. Il est ensuite testé et les microprocesseurs

de basse performance sont éliminés.

Après 2010, la poursuite des gains de performance nécessitera

le passage à une autre technologie, sans doute la photonique, qui a déjà permis des

progrès en télécommunications (utilisation de la fibre optique pour la transmission à

haut débit sur longue distance) et pour les mémoires de masse (CD-Rom). Ce passage

demandera du temps, et le progrès des performances sera ralenti pendant une période de

transition. Il ne faut pas s’en inquiéter : l’assimilation des apports du STC

par les entreprises est lent, et la pause des performances permettra de faire mûrir les usages.

Il y a là de quoi occuper les premières décennies du XXIème siècle.

Mémoires de masse

L’évolution des mémoires de masse est aussi déterminante

que celle des mémoires vives et processeurs. Sur les supports magnétiques, le coût du

stockage de 10 000 caractères est passé de 150 000 francs en 1955 à 100 francs en 1980

et à 1 centime en 1995. La densité des enregistrements magnétique est de plusieurs

millions de caractères par cm2. L’augmentation de la densité accroît le

volume des mémoires, et aussi la vitesse de lecture des données. Cependant elle réduit

l’intensité du champ magnétique utilisable et les limites de cette technique seront

bientôt atteintes.

L’enregistrement optique prend le relais. L’énergie

nécessaire à la lecture n’est plus stockée dans le support. La capacité actuelle

d’un CD-Rom est de 600 millions de caractères. Les industriels se sont mis

d’accord en 1995 sur le standard qui la portera à 6,4 milliards de caractères sur

un CD-Rom.

Concurrence

entre mainframe et micro-ordinateur

La concentration de puissance et de mémoire sur le

micro-ordinateur concurrence le gros ordinateur : à travers la mise en réseau et la

" scalability " (cf. annexe), le micro-ordinateur devient le support

d’une performance analogue à celle des supercalculateurs.

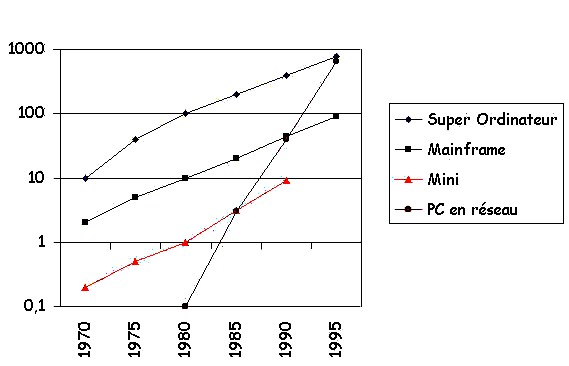

Evolution des performances (en Mips)

Coût

comparé des micro-ordinateurs et " mainframes "

La fabrication d’un ordinateur étant est une industrie à

coûts fixes, le prix dépend de la taille du marché. C’est ce qui explique la déséconomie

d’échelle qui caractérise le marché des ordinateurs : plus un ordinateur est

gros, plus l’unité d’œuvre coûte cher.

| |

IBM 3090 |

Serveur

Unix |

PC |

MIPS |

300 000 F |

2 500 F |

20 F |

Mo

disque |

50 F |

10 F |

1 F |

Mo RAM |

30 000 F |

700 F |

50 F |

Source |

Ovum Ltd |

Sun |

PC

direct |

Comparaison des prix des matériels (3)

En effet, comme le marché des gros ordinateurs est plus étroit

que celui des PC, le coût de leur conception et de leur mise en production doit

s’équilibrer sur un plus petit nombre d’unités, et le prix unitaire à

performance équivalente est plus élevé.

Cette déséconomie d’échelle explique la tendance

irrésistible à la décentralisation de la puissance et de la mémoire des ordinateurs

(architectures client / serveur, " downsizing " etc.).

L’utilisation des ressources est physiquement plus efficace si elles sont

concentrées sur une seule machine sécurisée utilisée à temps complet. Mais

l’utilisation économiquement efficace des ressources est celle que l’on

obtient en disséminant processeurs et mémoires et en les reliant par un réseau, même

si chaque PC n’est utilisé que quelques pour cent du temps. Cela offre des

ressources physiques d’un coût unitaire beaucoup plus bas. Les recherches sur le

multi-ordinateur (" scalability ") visent même à faire remplacer

complètement le mainframe par des PC en réseau (4).

Evolution du prix

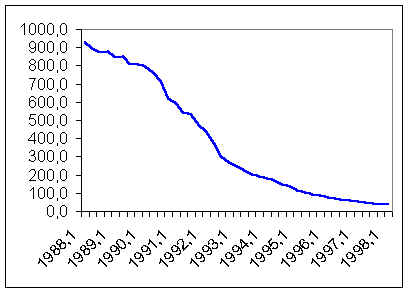

NB : pour suivre cet indice, il faut consulter l'INSEE (par

minitel : 36 17 PVI, code PVIC300201)

Un coup d’œil sur l’indice des prix des suffit à

l’économiste pour comprendre qu’il se passe quelque chose d’important. Cet

indice baisse depuis 1990 de 30 % par an ; une telle baisse est de nature à briser

toutes les résistances, à défoncer tous les " prix de

réservation " que directeurs financiers et ménages peuvent avoir en tête.

Celui qui ne " veut pas en entendre parler " oubliera inévitablement

ses réticences en quelques années, et alors il " s’y mettra ".

L’indice INSEE du prix de vente industriel des

micro-ordinateurs (5) est établi, conformément aux méthodes classiques en matière

d’indice de prix, à qualité constante.

Il décrit donc non l’évolution du prix moyen des

micro-ordinateurs (puisque la qualité du micro-ordinateur standard croît continûment),

mais l’évolution du prix qu’aurait un micro-ordinateur à qualité constante

si celui-ci était offert sur le marché durant la période couverte par l’indice.

Il s’agit donc de l’évolution du rapport " prix moyen constaté sur

le marché / qualité standard sur le marché ".

Source : INSEE, indice trimestriel du prix de

vente industriel des micro-ordinateurs (6)

La baisse, continue, accélère en 1990. La courbe prend alors

la forme d’une exponentielle décroissante, le taux de baisse étant

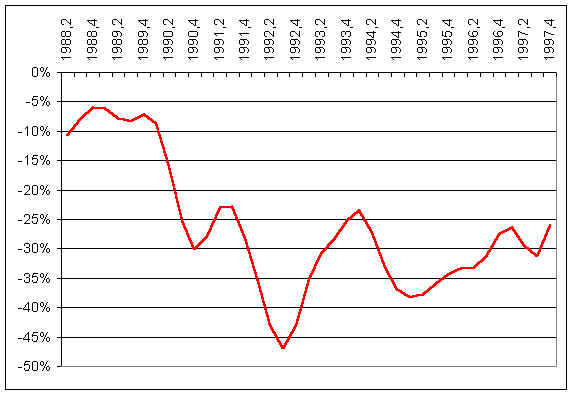

approximativement constant. Pour mieux comprendre cette série, observons son taux de

variation en équivalent annuel (le niveau " - 30 % " sur ce graphique

signifie que l’indice a évolué ce trimestre-là à un taux qui, sur un an,

correspond à une baisse de 30 %) (7) :

Cette courbe montre que le taux de baisse annuel se situe

actuellement entre 30 et 40 %, et tout fait prévoir que ce rythme va se maintenir. Nous

n’avons pas connaissance d’autres évolutions aussi rapides et aussi prolongées

d’un prix industriel. Ce phénomène a des conséquences : nombre de vendeurs de PC,

très prospères au début des années 1990, ont été ruinés par la dévalorisation

rapide de leur stock. Ceux qui ont survécu ont appris à " tourner "

avec un stock très faible (exemple : Dell).

Le prix moyen de l’ordinateur baisse moins vite que

l’indice de prix, puisque la qualité augmente. Cependant il diminue: il était de 35

000 F en 1990, 17 000 F en 1994, il est aux alentours de 8 000 F en 1998, soit une baisse

de 17 % par an. Il est donc erroné de croire que la baisse de l’indice serait

compensée par l’effet qualité, le prix restant constant parce que les machines se

compliquent. La baisse de l’indice de prix, 35 % par an, s’explique pour moitié

par la hausse de la qualité, pour moitié par la baisse du prix moyen.

Si l’on combine l’évolution du coût du PC et la

déséconomie d’échelle, on obtient un effondrement du prix à performance

égale :

- au début des années 1980, le superordinateur Cray 1, capable de traiter 100

MIPS, était vendu 60 MF. Il nécessitait une grande salle machine et des équipements de

climatisation.

- en 1996, la machine multimédia de base pour le grand public est un

micro-ordinateur de même puissance, à base de Pentium 100, doté de la même capacité

mémoire. On le fait fonctionner sur un bureau, sans prendre de précautions

particulières. Son prix est d’environ 10 000 F, soit en francs constants 15 000 fois

moins que le Cray 1.

Baisse du prix moyen des micro-ordinateurs (en kF) (8)

Logiciel

La fonction de production du logiciel est à coût fixe : une

fois le programme écrit, le coût marginal de sa reproduction sur un nombre de supports

quelconque est négligeable.

Les progrès du logiciel sont déterminants pour la

pénétration des ordinateurs dans toutes les activités industrielles ou intellectuelles.

Ils concernent les langages de programmation, les interfaces utilisateur, les outils de

développement.

Le coût de production du logiciel diminue, mais beaucoup plus

lentement que celui du matériel (4 % par an pour le logiciel, contre 35 % par an pour le

matériel). L’enjeu du coût du logiciel, jugé mineur aux débuts de

l’informatique, est devenu primordial.

Langages

Les progrès des langages peuvent être décrits selon le

modèle en couches de l’informatique. Initialement les programmeurs devaient écrire

dans le langage machine de l’ordinateur, dont le vocabulaire consiste en nombres

binaires représentant les adresses mémoire et les codes des opérations. Mais ce langage

est pénible pour les êtres humains.

Le langage " assembleur ", plus commode,

code les opérations avec des caractères alphabétiques (ADD pour l’addition, SUB

pour la soustraction etc.). Néanmoins il fallait des langages encore plus proches du

langage humain.

Le premier langage " de haut niveau " fut

FORTRAN (" Formula Translation ") en 1954. Ses instructions

ressemblaient à des formules mathématiques, et il était adapté aux besoins des

scientifiques et mathématiciens. Mais il n’était pas commode pour les travaux peu

mathématiques, notamment les applications de gestion. COBOL (Common Business-Oriented

Language, 1959) répond à ce besoin. Il emploie des mots et une syntaxe proches de

l’anglais courant.

D’autres langages encore plus commodes furent introduits

ensuite : BASIC (Beginner's All-Purpose Symbolic Instruction Code, 1964) peut être

rapidement maîtrisé par le profane ; il utilisé dans les écoles, entreprises et

ménages. C est un langage de haut niveau qui peut fonctionner comme un assembleur ;

beaucoup de logiciels d’entreprise sont écrits dans ce langage souple. Pascal (1971)

est largement utilisé pour les PC et les mini-ordinateurs.

D’autres langages de haut niveau sont adaptés à des

applications précises :

- APT (Automatically Programmed Tools) pour le contrôle des machines outils

numériques,

- GPSS (General-Purpose Simulation System) pour la construction des modèles de

simulation,

- LISP (List Processing, 1960) pour manipuler des symboles et des listes plutôt

que des données ; il est souvent utilisé en intelligence artificielle.

Les langages de quatrième génération (4GL), utilisés

principalement pour la gestion et l’interrogation des bases de données, sont

plus proches encore du langage humain. On peut citer FOCUS, SQL (Structured Query

Language), et dBASE.

Les langages orientés-objet comme C++ ou Smalltalk permettent

d’écrire des programmes fondés sur des objets réutilisables, modules rassemblant

un petit nombre de données et de traitements et communiquant entre eux par messages.

Pour les systèmes d’exploitation, les fonctions offertes

à un programme développé en 1966 sous l’OS des IBM 360 étaient pratiquement les

mêmes que celles disponibles sous la dernière version OS/390. La première version

d’Unix a été développée en 1969, les bases de données relationnelles sont nées

en 1970.

Selon la thèse de Church-Turing, (9) " tout langage

de programmation non trivial imaginable est capable de calculer ni plus ni moins de

fonctions qu'un autre langage de programmation non trivial ". Tous les langages

non triviaux sont donc équivalents à une machine de Turing. Cependant il ne faut pas

surestimer la portée de cette équivalence (10) : un simple câble, un pont de

lianes et le Pont de la Concorde permettent tous de traverser la Seine – mais pour

utiliser le premier il faut être un équilibriste, le second exige une bonne forme

physique, seul le troisième est vraiment commode. Dans le domaine des langages, la

qualité et la commodité résident dans les structures de contrôle de programmes, les

environnements et les outils de programmation.

Interfaces utilisateur

Si le programme transforme l’ordinateur en outil adapté à

un usage particulier, l’interface utilisateur sert d’intermédiaire entre

l’utilisateur et le programme. L’invention de la souris et des fenêtres par

Xerox en 1973 a donné naissance à Star en 1978, à Lisa en 1982, puis en 1984 au

Macintosh d’Apple, premier produit offrant une interface graphique qui ait connu la

réussite sur le marché. Il a été suivi en 1990 dans le monde du PC par Windows 3.0 de

Microsoft.

Le principe le plus important de l’interface graphique a

été le Wysiwyg (" What You See Is What You Get "). Chaque

manipulation de l’image sur l’écran entraîne une modification prévisible de

l’état du système. Les éléments de cette métaphore sont les fenêtres (Windows),

menus, icônes, boutons, onglets, et le pointeur. Les fenêtres permettent la

représentation simultanée de plusieurs activités sur l’écran. Les menus

permettent de choisir les prochaines actions. Les icônes, boutons, onglets etc.

attribuent une forme concrète aux objets informatiques. L’outil de pointage, souris

ou track-ball, sélectionne fenêtres, menus, icônes etc.

Evolution

Au début de l’informatique, le coût de la programmation

n’était pas jugé critique. Si une machine coûtait 10 MF, le logiciel pouvait bien

coûter 1 MF. Si la durée de vie du matériel était de dix ans, le développement du

logiciel pouvait bien prendre deux à cinq ans. Mais la baisse rapide du coût des

matériels a rendu critique le coût des logiciels, dont l’évolution est beaucoup

plus lente.

Si on utilise pour mesurer la productivité du logiciel la

méthode des points de fonction, on trouve la courbe suivante sur les cinquante dernières

années :

Coût moyen du logiciel en Francs par point de fonction

Le coût du logiciel a baissé depuis cinquante ans

d’environ 20 % tous les cinq ans, soit 4 % par an. Le Cobol représente 80% du

logiciel produit depuis 1960, et il y a encore au moins un million de programmeurs Cobol

dans le monde. Ils sont trop occupés à maintenir les programmes Cobol pour innover.

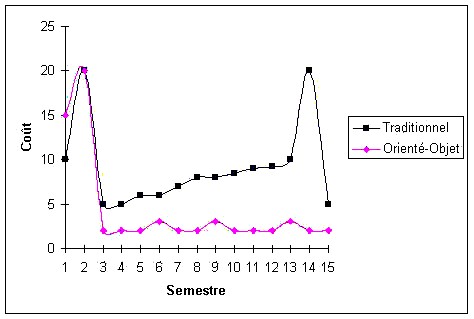

Chronologie des coûts de développement en mode

traditionnel et en mode orienté objet.

Des progrès sont toutefois prévisibles ; ils vont venir

de la minorité de programmeurs qui n’utilisent pas Cobol, mais des langages

orientés-objet. Si ces langages n’augmentent pas sensiblement la productivité des

développeurs, ils facilitent l’évolution des logiciels et permettent de réduire

les coûts de maintenance (cf. graphique ci-dessus). On estime que le coût annuel de

maintenance du logiciel est dans les premières années de l’ordre de 10 à 15 % du

coût du développement, et qu’il tend ensuite à croître : il convient de

refaire le logiciel à neuf lorsque le coût de maintenance annuel atteint 30 % du coût

de réfection. Avec l’orienté objet, la maintenance est moins coûteuse (coût

annuel de l’ordre de quelques pour cent du coût de développement) et

l’évolution est plus aisée, ce qui permet d’éviter les réfections.

Par ailleurs les outils de développement visuels (interfaces

graphiques, générateurs de programmes) accroissent la productivité dans un rapport de 1

à 5. Ces outils, d’abord dédaignés par les " vrais

programmeurs " adeptes de C ou C++, permettent de produire les lignes de code en

manipulant des icônes et des menus. Grâce à une plus grande facilité de création ou

de modification, les programmeurs " à la souris " gagnent du terrain

comme en atteste la percée de Visual Basic, y compris pour le développement

d’applications professionnelles.

Le futur programmeur s’appuie sur des outils visuels, des

techniques objets et des bibliothèques de composants. Ainsi, et en rupture avec les

tendances antérieures, il se peut que la baisse du coût des logiciels accélère dans

les prochaines années.

Marché

La vivacité de la concurrence entre fournisseurs contribue à

expliquer la baisse du prix des ordinateurs. Rappelons quelques dates qui ont marqué

l’histoire de cette concurrence :

- L’Altair, le premier micro-ordinateur commercialisé en 1974 était vendu en

kit et peu utilisable ;

- Apple offre le Macintosh en 1984 ;

- IBM sort le PC standard en 1981 ; il se fait " doubler " par

Compaq sur le marché des portables en 1982 ;

- Microsoft, fournisseur du système d’exploitation du PC, et Intel,

fournisseur du microprocesseur, trouvent alors des clients chez les fabricants de

" clones " qui raflent à IBM la plus grosse part du marché (11).

Par la suite, les progrès des systèmes d’exploitation

(12), des applications, des processeurs et mémoires sont autant d’occasions pour

relancer la concurrence, différencier les produits (tout en restant compatible avec le

standard PC) et tailler de nouvelles niches de marché. On dénombre aujourd’hui 200

millions d’ordinateurs installés (13), et depuis 1995 il se vend dans le monde plus

de PC que de téléviseurs. La vivacité de l’innovation entraîne un

raccourcissement de la durée de vie du PC (deux à trois ans pour l’usage

professionnel), ce qui garantit un marché de renouvellement.

Alliances pour la conception des

ordinateurs (14)

" In

computers, ease of use with equivalent performance varies with the square root of the cost

of development. This means that to design a computer that ’s ten times easier to

use than the Apple II, as the Lisa was intended to be, would cost 100 as much money. Since

it cost around $500,000 to develop the Apple II, [this Law says that] the cost of building

the Lisa should have been around $50 million. It was.

" [If you wait to]

buy a computer that is ten times as easy to use as the Macintoch, remenber that it’s

going to cost around $5 billion to develop. Apple R&D budget is about $500 million, so

don’t expect that computer to come from Cupertino. IBM’s R&D budget is about

$3 billion, but that’s spread across many lines of computers, so don’t expect

your ideal machine to come from Big Blue either. The only place the computer world is

going to come from, in fact, is a collaboration of computer and semiconductor companies.

That’s why the computer world is suddenly talking about Open Systems, because

building hardware and software that plug and play across the product lines and R&D

budgets of a hundred companies is the only way that future is going to be born. Such

collaboration, starting now, will be the trend in the next century ".

Le micro-ordinateur constitue le

phénomène économique le plus important de notre époque, comme le firent en

d’autres temps la machine à vapeur, le moteur électrique ou le moteur à explosion.

C’est la machine emblématique du STC, celle où se condensent les synergies

caractérisant ce système, celle dont la qualité et le prix tirent au mieux parti de ces

synergies, celle qui a le plus d’effets sur les usages, celle dont le marché obéit

le mieux à notre modèle.

Son marché s’emballe, l’amélioration continue des

technologies de base alimentant une baisse du prix qui induit un élargissement du

marché, provoquant lui-même une nouvelle baisse de prix. Il se diversifie : du

" desktop " au " laptop " portable, puis au

" palmtop " qui tient dans le creux de la main et qui, muni

d’une antenne, apporte toutes les facilités du PC en réseau (15). Toute machine qui

comporte un microprocesseur et une mémoire vive est un ordinateur en puissance (il suffit

de lui connecter un clavier et un écran) : ce sera bientôt le cas de la plupart des

équipements ménagers, automobiles etc.

Le micro-ordinateur équipe aujourd’hui le poste de travail

typique du salarié dans les activités de service, qui représente 70 % de l’emploi

et dont l’importance va croissant. Pour mettre ce salarié au travail, il faut lui

fournir quelques m2 d’espace bien éclairé et bien aéré, un siège, un

bureau, un espace de rangement - et un micro-ordinateur relié au réseau de

l’entreprise. Le coût de l’équipement informatique d’un salarié

(micro-ordinateur, plus quote-part des serveurs et du réseau, plus coût des logiciels)

est d’environ 20 kF, soit 6 kF/an si l’on tient compte de la durée de vie

(typiquement trois ans). Ce coût baisse rapidement, et il est déjà plus faible que le

loyer des m2 de bureau (16). Au coût d’équipement, il faut ajouter un

coût d’exploitation du même ordre de grandeur, couvrant l’assistance aux

utilisateurs, la maintenance, l’administration des droits d’accès,

l’animation des services de travail coopératif (messagerie, forums, workflows etc.).

Travail et communication s’organisent autour de cet outil.

Celui qui ne l’utilise pas (c’est encore le cas de la majorité des managers)

risque de se trouver en dehors du réseau de l’entreprise, en prenant le mot

" réseau " non seulement au sens physique, mais au sens symbolique de

lieu de communication. La pénétration du micro-ordinateur est irrésistible,

l’effet d’avalanche propre à la logique du réseau étant renforcé par une

baisse de prix rapide, prolongée, qui efface toutes les réticences.

Conclusion

La fonction à coût fixe qui caractérise l’économie du

micro-ordinateur, qu’il s’agisse du logiciel, du matériel ou des réseaux, a

pour conséquence que ce marché obéit à une logique de différenciation et de

concurrence monopoliste. Les exigences en matière de standardisation ne changent rien à

cette situation : elles constituent le cadre de la différenciation, sans

l’annuler (de même, la différenciation des cravates ou des chemises se fait dans un

cadre, celui du produit " cravate " ou du produit

" chemise ", qui constitue un standard de référence mais

n’empêche pas leur différenciation).

La dynamique du marché est soutenue :

- par l’effet d’avalanche qui caractérise tout réseau une fois atteint

le seuil critique de pénétration, ce qui est le cas au moins en ce qui concerne

l’équipement des emplois de service,

- par la baisse tendancielle des coûts, très rapide pour le matériel (35 % par

an), moins rapide pour le logiciel (4 % par an, avec une tendance à

l’accélération),

- par une innovation soutenue favorisant la constitution de nouvelles niches de

marché.

La concurrence entre fournisseurs est violente. Naissance,

croissance et disparition des entreprises sont rapides, les valorisations en bourse

précoces, les restructurations fréquentes. La presse est pleine des aventures des

concurrents : Sun, Microsoft, Netscape, Compaq, Apple, etc. Des entreprises modestes

deviennent en quelques années des empires, puis ces empires sont mis soudain en

difficulté. Les formes de concurrence et de développement propres à ce secteur

illustrent notre modèle.

L’écart entre les rythmes de baisse des coûts du logiciel

et du matériel déplace la question critique : elle résidait autrefois dans le

matériel, elle se trouve aujourd’hui dans le logiciel.

La question critique du futur se trouve non dans le logiciel,

mais dans les usages des micro-ordinateurs en réseau. Le point de blocage de

l’évolution se trouve en effet dans l’aptitude des entreprises et des

particuliers à se réorganiser pour tirer pleinement parti des possibilités offertes.

Nous y reviendrons dans la partie IV.

- (1) Gordon Moore, co-fondateur et vice président d’Intel, a découvert cette loi

en 1971.

- (2) Michael S. Malone " The Microprocessor, a Biography "

Springer-Verlag 1995

- (3) Jean-Paul Figer " Les grandes tendances de l’évolution de

l’informatique 1950-2010 " 1996. Ce chapitre doit beaucoup à Jean-Paul

Figer.

- (4) Witold Litwin " High-Availability LH* Schemes with Mirroring "

COOPIS 1996 (Annexe 1)

- (5) Emmanuel Delame " Les bouleversements du marché de la

micro-informatique " INSEE Première septembre 1995

- (6) calculé en enchaînant les indices base 100 1990 et 1995

- (7) Pour améliorer la lisibilité du graphique, le taux de variation est calculé à

partir d’une moyenne mobile sur trois trimestres renouvelée deux fois.

- (8) Emmanuel Delame, op. cit.

- (9) Alan W. Biermann " Great Ideas in Computer Science " MIT Press

1997

- (10) David Harel " Algorithmics " Addison-Wesley 1993

- (11) Paul Carroll " Big Blues, the Unmaking of IBM " Crown

Publishers 1994

- (12) Andrew Tanenbaum " Operating Systems. Design and

Implementation " Prentice-Hall 1987

- (13) Au début des années 50, une étude de marché restée célèbre évaluait le

marché mondial à une cinquantaine d’ordinateurs.

- (14) Robert X. Cringely " Accidental Empires " Harper Business 1992

- (15) David Bennahum " Nine Ounces of Freedom " Wired juin 1998.

- (16) 15 m2 à 1 ou 2 kF, soit de 15 à 30 kF par salarié et par an

|